Adicionar Storage partilhadas Nfs e Ceph ao Datacenter

Criado o Cluster de Proxmox VE, o servidor de NFS e o Cluster de Ceph, é altura de adicionar estas storage partilhadas ao “Datacenter” de Proxmox, que é constituído pelos quatro servidor.

Mas primeiro vamos fazer uma pequena alteração na storage local de cada servidor, visto que não a vamos usar.

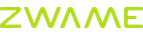

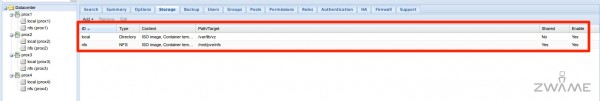

Para tal, no menu do lado esquerdo, vamos aceder a “Datacenter“, à tab “Storage“. Escolhemos a storage “local” e carregamos em “Edit“.

Na opção “Content” vamos tirar todas as opções, mantendo apenas “ISO image” e “Container template“. Assim a storage “local“, só pode servir para estas duas finalidades. No fim, carregar no botão de “OK“.

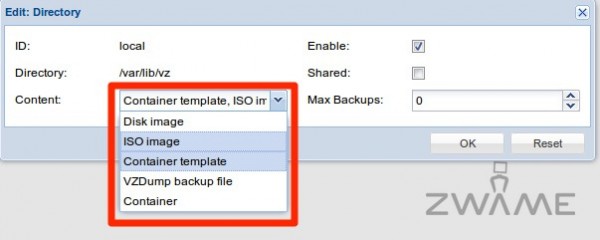

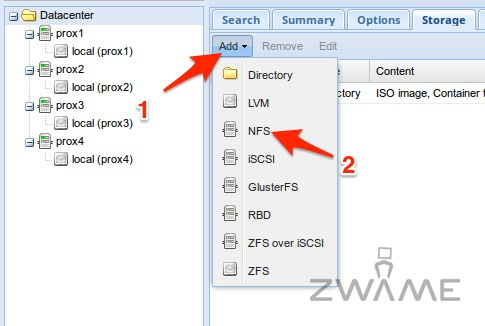

Vamos então adicionar a storage partilhada do servidor de NFS. Para tal, no mesmo tab de “Storage” em “Datacenter“, vamos carregar no botão de “Add” e da lista escolhemos “NFS“.

No “ID” podemos colocar o nome que preferir-mos. Eu escolhi “nfs“. No “Server” coloca-se o ip do servidor de NFS, o “192.168.10.210“, no “Export” coloca-se a diretoria “/isos” e na opção “Content” vamos tirar todas as opções, mantendo apenas “ISO image” e “Container template“, pois só queremos a storage de NFS para esta finalidade e não para discos das máquinas virtuais. No fim, carregar no botão de “Add“.

Podemos ver que dentro da “Storage” do “Datacenter” ficamos com as storage “local” que não é partilhada entre os servidores e a storage “nfs” que é partilhada entre os quatro servidores.

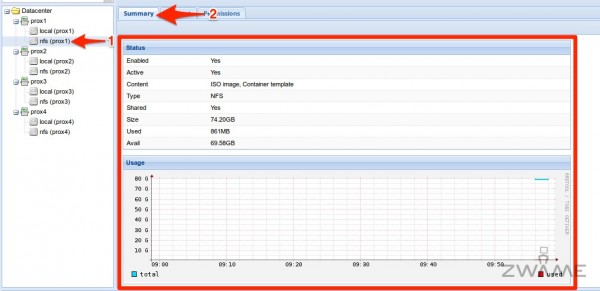

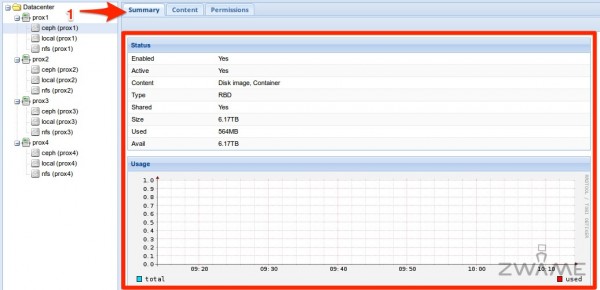

Dentro de cada servidor, por exemplo o “Prox1” temos uma storage “nfs” e se carregarmos nele, vamos para a tab “Summary” onde vemos os detalhes e gráficos relacionados a esta storage.

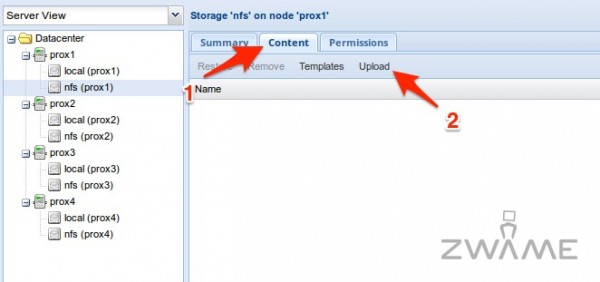

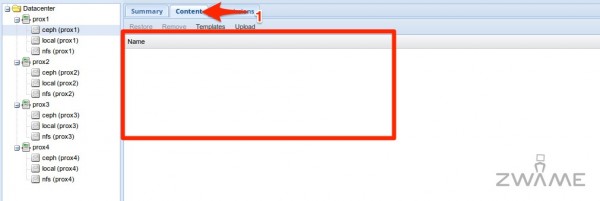

Para adicionarmos um ficheiro ISO à storage “nfs“, vamos ao tab “Content” e carregamos no botão “Upload“.

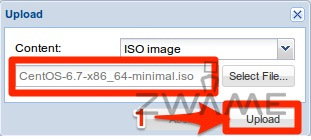

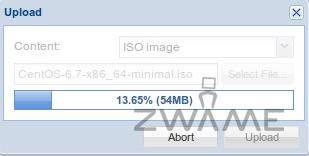

Aparece uma janela, onde no “Content” escolhemos “ISO image” e carrega-se no botão “Select file” para fazer “browse” ao computador onde estamos a gerir o Proxmox e escolhermos o ficheiro ISO que queremos fazer upload.

Escolhido o ficheiro ISO, podemos avançar carregando no botão “Upload“.

Vai aparecer uma janela com a percentagem de upload do ficheiro. É esperar que ele acabe.

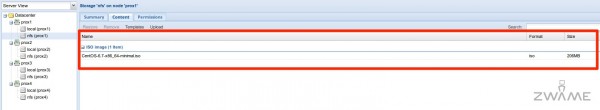

Acabado o upload do ficheiro, o ISO vai aparecer dentro da storage “nfs“.

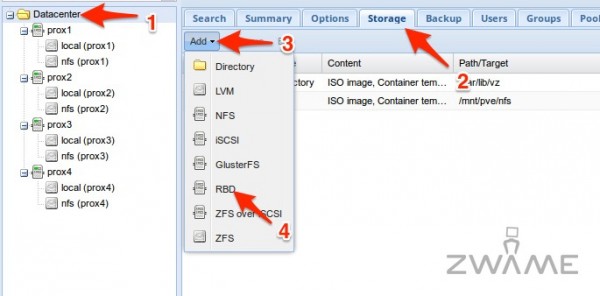

Em seguida vamos adicionar a storage “ceph” ao “Datacenter“, onde vão ficar os discos das máquinas virtuais e de containers. Para tal, devemos ir ao menu do lado esquerdo e escolher “Datacenter“. Escolher do lado direito a tab “Storage“. Dentro deste tab, carregar no botão “Add” e no menu que aparece, escolher a opção “RBD“.

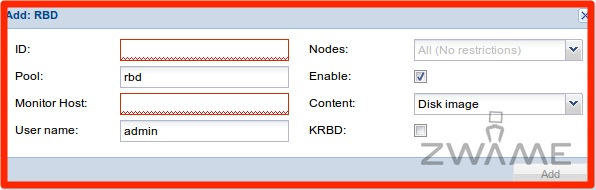

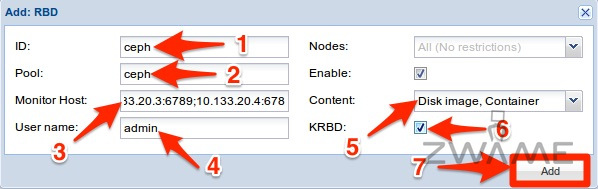

Aparece um menu com várias opções. Aqui vamos ter que fazer várias alterações para adicionarmos a storage “ceph“.

O “ID” pode ter o nome que melhor acharem. Eu escolhi “ceph”. A “Pool” é “ceph” que criamos à bocado. No “Monitor Host” vamos colocar todos os “monitors” que criamos, escrevendo “10.133.20.1:6789;10.133.20.2:6789;10.133.20.3:6789;10.133.20.4:6789“. O “User Name” colocamos o de default, “admin“. No “Content” escolhemos “Disk image” e “Container” e escolhemos a opção “KRBD” para melhor performance. Finalizar carregando no botão “Add“.

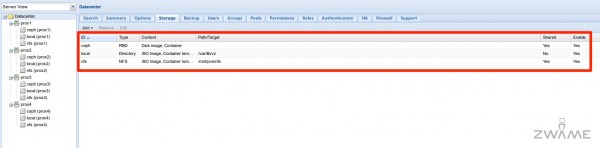

Dentro da tab “Storage“, vemos agora as storage “local“, “nfs” e “ceph“. Por baixo de cada servidor vamos ter também a storage “ceph“, que é a storage distribuída entre os 4 servidores.

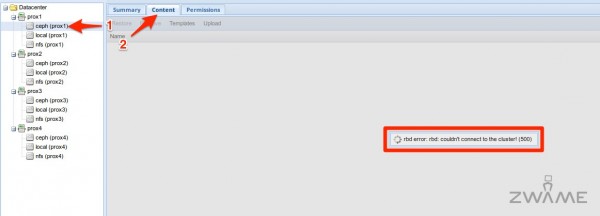

No entanto, se formos a um dos servidores e escolhermos a storage “ceph” e depois escolhemos a tab “Content“, recebemos o seguinte erro “rbd error: couldn’t connect to the cluster! (500)“. Isto acontece porque o cliente de Ceph quando se tenta ligar aos “monitors” não se consegue autenticar. O Ceph usa uma chave do utilizador “admin” para os cliente se ligarem aos “monitors” e falta adicionar essa chave ao cliente de Ceph do cluster.

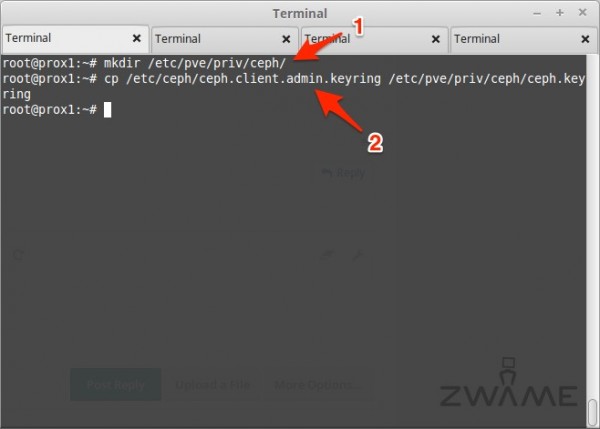

Para tal, acedemos a um dos servidores e apenas a um deles, por exemplo o “Prox1” por ssh e corremos o comando:

mkdir /etc/pve/priv/ceph/

Para criamos a diretoria “ceph” dentro da diretoria de controlo do cluster.

Em seguida corremos o comando:

cp /etc/ceph/ceph.client.admin.keyring /etc/pve/priv/ceph/ceph.keyring

Sendo que o ceph a bold tem que ser o mesmo nome que se deu no “ID” na criação da storage.

Depois de executado o comando anterior, podemos aceder à storage “ceph” por baixo de qualquer servidor, aceder à tab “Content“, já não dá erro e vemos a storage, que por enquanto está vazia.

Se acedermos à tab “Summary” da storage “ceph“, temos os seu detalhes, como o espaço total e que está partilhada pelos diferentes servidores.